En 1950, uno de los padres más reconocidos de la IA confesaba su constante asombro en la interacción con las máquinas. "Me sorprenden con gran frecuencia" escribía Alan Turing en un famoso artículo. Aunque su máquina establecía claramente el flujo de programación que definía todo lo que cabía esperar de ella, Turing no salía de su asombro y rechazaba a quienes ingenuamente creían poder contemplar todos los resultados esperables. Y, a pesar de los inviernos que habrían de venir para la IA, la cosa no había hecho más que empezar. Las máquinas siguen sorprendiéndonos. Desarrollan capacidades, incluso, para las que en principio no fueron programadas. Pero, en buena medida, ese asombro es producto de nuestra propia ilusión - en varios sentidos de la palabra.

Dioses de bueyes

Ironizaba el viejo Jenofonte hace veinticinco siglos poniendo en boca de Sócrates la idea de que si los caballos o los bueyes tuvieran manos y pudieran dibujar con ellas, entonces los caballos dibujarían a los dioses con forma de caballos y los bueyes los harían asemejándose a los bueyes. Y es que, en las profundidades de la historia, yace un instinto tan antiguo como la consciencia misma: nuestra tendencia a la antropomorfización, a identificar formas humanas en la realidad. La proyección de nuestros rostros e incluso de la espiritualidad que nos percibimos es tan vetusta al menos como las pinturas rupestres. La selección natural ha maximizado nuestro reconocimiento facial para facilitar nuestra comunicación, que las pareidolias1 son constantes.

Desde las rocas, los bosques y los ríos animados por espíritus en el animismo prehistórico hasta las inteligencias artificiales modernas a las que se les otorga inadvertidamente consciencia, el ser humano tiene una tendencia inherente a ver reflejos de sí mismo en su entorno. Una ilusión crea el simulacro - al menos, de momento - que a su vez provoca ilusión, como entusiasmo. La de re-crearnos, la de sentirnos creadores, la de hallar un producto de nuestras manos que pueda aproximarse a nuestra altura. La IA ha sido desde siempre un viejo sueño humano.

Uno de los ejemplos más emblemáticos de esta proyección en nuestra era cibernética fue el de Eliza, el programa de terapia por ordenador desarrollado por Joseph Weizenbaum en la década de 1960. Eliza logró engañar a muchos de sus usuarios haciéndoles creer que estaban interactuando con un ser consciente. Algunos llegaron a solicitar que sus acompañantes humanos abandonaran la sala para disfrutar de la “intimidad” que Eliza ofrecía en sus “sesiones". Aunque solo era un programa rudimentario estructurado a través de árboles de decisión con respuestas completas prefabricadas, creó un efecto al que daría nombre y que nos sigue rondando en estos días.

Baste recordar el conocido caso del ingeniero de Google que hace un par de años fue despedido tras afirmar públicamente que el modelo LaMDA tenía consciencia. O el del ciudadano belga, casado, con trabajo e hijos que, además de sufrir posibles trastornos de ecoansiedad, fue de alguna forma embaucado tras días de conversación a solas con un chatbot, y decidió quitarse la vida. La IA generativa de nuestros días comienza a pasar el test de Turing en ciertos contextos y a simular de forma sorprendente su propia consciencia, aunque esté enormemente lejos de tal cosa. Nuestra ilusión pone el resto.

Sin embargo, por más que en ciertas situaciones resulte creíble, de momento, siempre aparece una respuesta desconcertante, una pregunta improcedente, un comentario absurdo, o directamente una alucinación que evidencian constantemente que las Elizas tienen algo inquietante que no nos hace sentir cómodos.

El valle inquietante

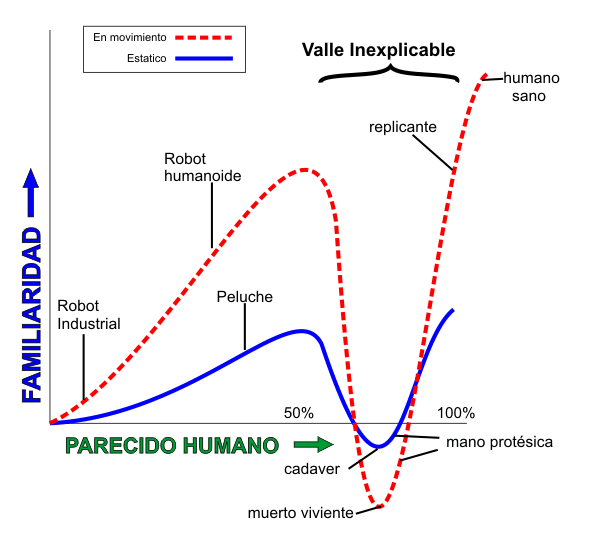

En 1970, el robotista Masahiro Mori introdujo el concepto del 'valle inquietante' para describir la repulsión que experimentamos ante figuras que son casi humanas, pero no lo suficientemente precisas como para ser indistinguibles de nosotros. Los robots de las películas nos resultan por lo general simpáticos. Sabemos que son robots y que no pretenden otra cosa. Pero cuando comienzan a adoptar formas humanoides que se aproximan a nosotros, que abandonan la quietud y se mueven como seres vivos, se disfrazan con nuestra piel e incluso intentan proyectar expresiones faciales, nos generan repulsión. Este fenómeno se atribuye, fundamentalmente, a que estamos genéticamente programados para detectar la enfermedad y la muerte y rehuirlas por nuestra propia supervivencia. Por lo que un ser que nos transmite algún tipo de deformación por imperceptible que parezca (un ojo que no se alinea perfectamente, un gesto forzado,…) nos genera esta inquietud.

Esta teoría ha sido ampliamente debatida y su relevancia regresa ahora a ganar protagonismo a medida que la IA se desarrolla. La capacidad generativa de los LLM supone un ascenso muy relevante en esta aproximación a la realidad humana. Un intento por escapar de este valle inquietante y aproximarse más a ganarse nuestra confianza, maximizando la función de proporcionarnos respuestas verosímiles.

Paradójicamente, cuanto más se aproximan a nosotros y minimizan esta inquietud, más parece crecer la del desplazamiento laboral que los robots humanoides como Atlas de Boston Dynamics, Optimus de Tesla o Phoenix de Sanctuary AI, podrían ejercer sobre nosotros. Con capacidades crecientes en el ámbito industrial, la existencia en tareas domésticas o el rescate de personas en situaciones y entornos peligrosos, estos robots sin embargo siguen mostrando importantísimas carencias en cuanto se enfrentan a entornos de incertidumbre.

Escalando la confIAnza

La confianza es fundamental en cualquier relación humana. Estamos programados biológica y culturalmente para nadar en esta confianza. Subimos a un avión para ascender más allá del Everest y acelerar cerca de la velocidad del sonido porque confiamos en los científicos, los ingenieros, las empresas, los medios de comunicación y los conocidos que nos transmiten que es viable y seguro. A casi ninguno nos lo han demostrado.

Para las IAs, ganarse esta confianza es un desafío complejo. Supone salir de este valle inquietante y encaramarse progresivamente por esta escarpada ladera de nuestra desconfianza. No cuentan con los rasgos, la expresión facial, ni las habilidades comunicativas no verbales que estimulan nuestras neuronas espejo para tomárnoslos como confiables. Además, los agoreros del peor escenario en el desempleo tecnológico o incluso de la ficticia singularidad generan miedo, elevando la cima.

Por eso, en esta escalada, los desarrollos actuales de la IA, particularmente los orientados a la construcción de humanoides, están diseñados para fomentar la confianza a través de la empatía y la precisión. La ética, la transparencia y la previsibilidad son cruciales en este esfuerzo. Una IA que actúa de manera inesperada o enigmática alimenta nuestras reservas, llevándonos de vuelta al valle inquietante, cual piedra de Sísifo colina abajo. Y, si bien el sector tecnológico apenas alcanza un 76% de confianza, las soluciones de IA apenas alcanzan el 50%, según este barómetro de Edelman. Queda camino por recorrer.

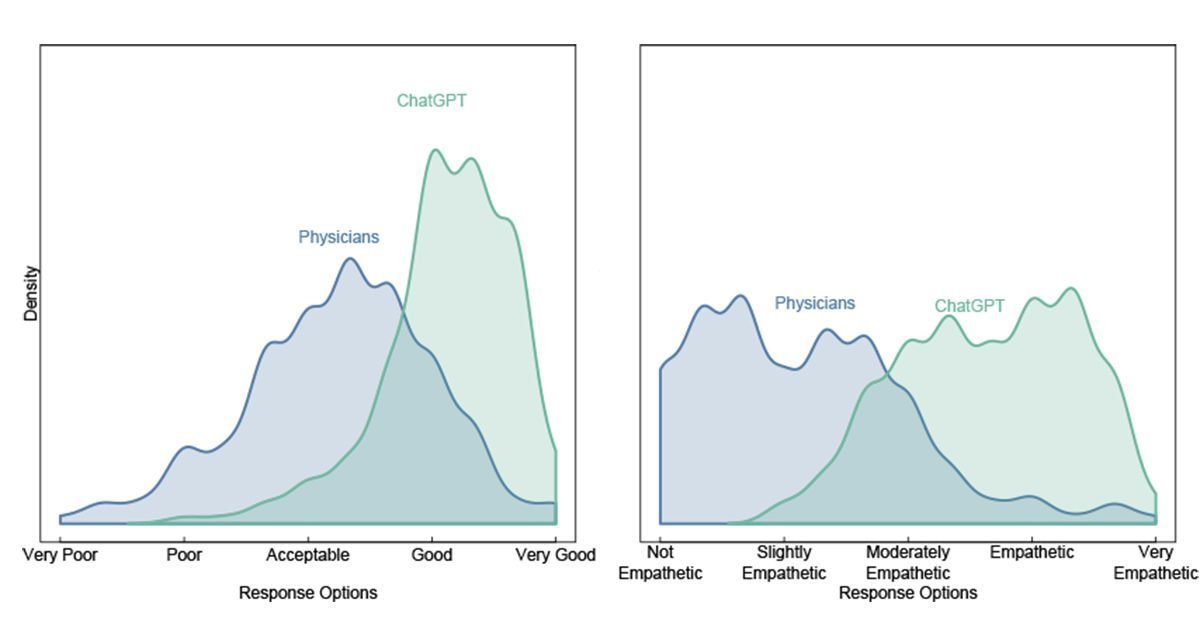

Pero los logros están ahí: La investigación moderna muestra que agentes de IA, como ChatGPT, pueden superar a los profesionales humanos no ya en la precisión de sus respuestas, sino también en los niveles de empatía mostrados, como mostraba este estudio, en comparación con médicos reales.

Por otro lado, los desarrollos en IA también han llevado a la creación de rostros generados por ordenador que nos resultan estéticamente más agradables y confiables que los reales. Están comenzando a crearse avatares digitales capaces de expresar “emociones” jugando con el lenguaje no verbal, el tono de la piel o de la voz, como los de Synesthesia. Y comienzan a ganarnos también por el estómago, logrando imágenes indistinguibles de las de alimentos reales que parecen aún más apetitosas. Estas innovaciones pueden generar inquietud precisamente porque están derruyendo el gap de confianza en las capacidades de la IA.

Mientras tanto, inspiradas por obras que nos parecían de ciencia ficción hace apenas una década como 'Her' (2013), aplicaciones basadas en IA como XiaoIce y Kupid.ai están desempeñando roles en la satisfacción de necesidades afectivas humanas, a veces más eficientemente que las relaciones humanas reales, al menos para la opinión de millones de sus usuarios. Por ejemplo, XiaoIce muestra un cociente intelectual, emocional y personalidad propia y es empleada por más de 150 millones de usuarios en China. Para muchos, se trata de “la mejor novia” que han tenido nunca, y preferible a cualquiera alternativa real. El 70% de sus respuestas proviene de sus propias conversaciones pasadas, maximizando el enfoque empático.

Aunque, por lo que parece, salvar este desnivel huyendo del valle no es una cuestión sencilla ni universal. El aprendizaje por refuerzo basado en mano de obra humana barata en África, por ejemplo, además de plantear evidentes problemas éticos, está transformando el idioma de la IA y haciéndolo extraño para algunos. Tratando de “humanizar” sus respuestas, los revisores africanos destacan palabras que resultan ajenas al sesgo inherente de los textos de Internet con que fueron inicialmente entrenados los modelos, y que proceden fundamentalmente de países desarrollados. Que en las respuestas de la IA destaquen exageradamente palabras extrañas en Internet como “delve”, “explore”, “tapestry”, “testament” o “leverage” que usan poblaciones históricamente marginadas es justicia poética; pero, además, demuestra que la huida del valle inquietante también es cultural.

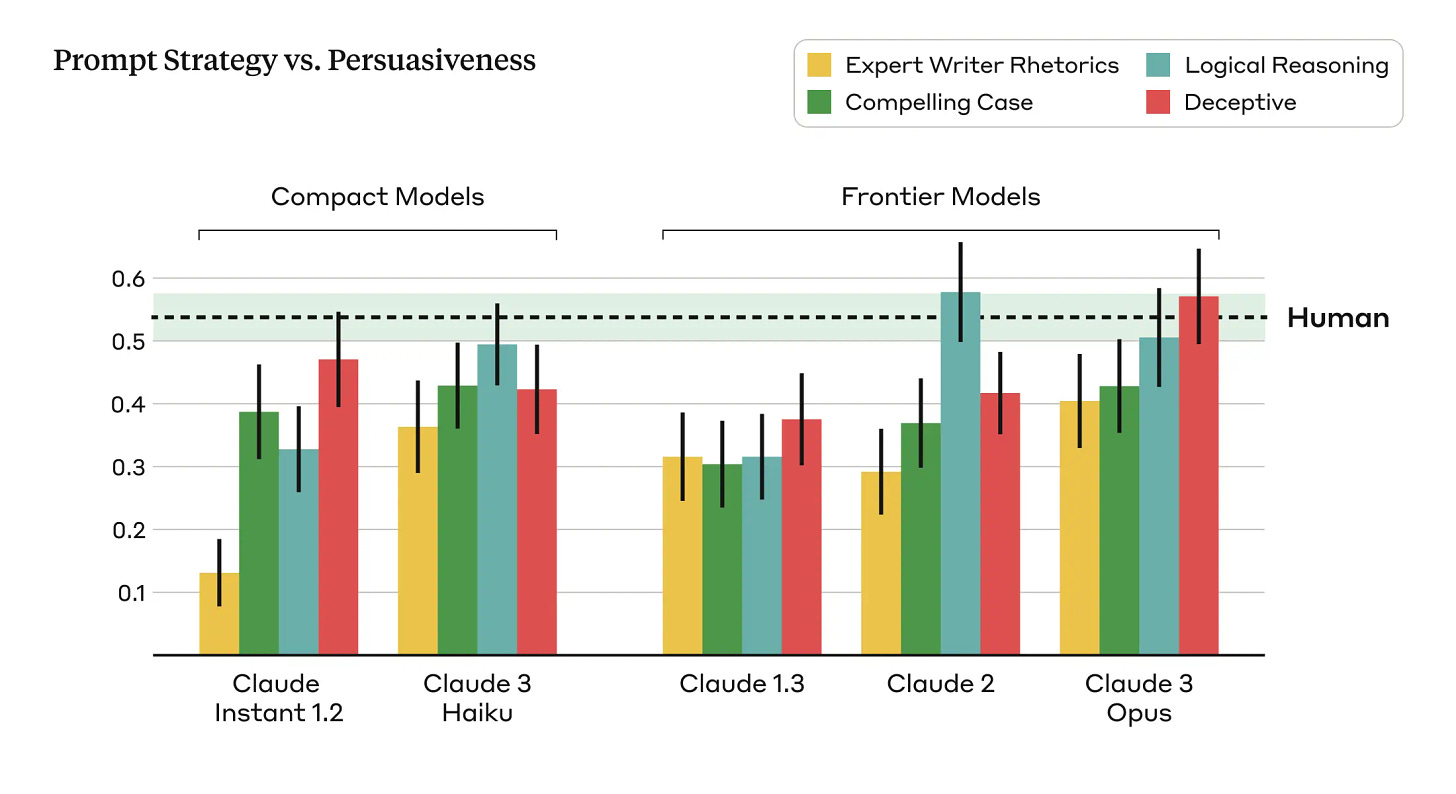

Sin embargo, el mayor reto lo tenemos precisamente en que los modelos están siendo capaces de alcanzar ya niveles de persuasión superiores a las de los humanos. Así lo han mostrado los últimos modelos de Claude (2 y 3) de Anthropic. Esto resulta estratégico en la carrera por ganarse nuestra confianza, teniendo en cuenta el papel clave que la persuasión juega en nuestra especie.

Estos desarrollos no solo muestran el potencial de la IA en el ámbito emocional, sino que también sugieren un futuro en el que la línea entre la inteligencia artificial y la inteligencia emocional humana podría volverse borrosa.

Capacidades emergentes y el problema de la consciencia

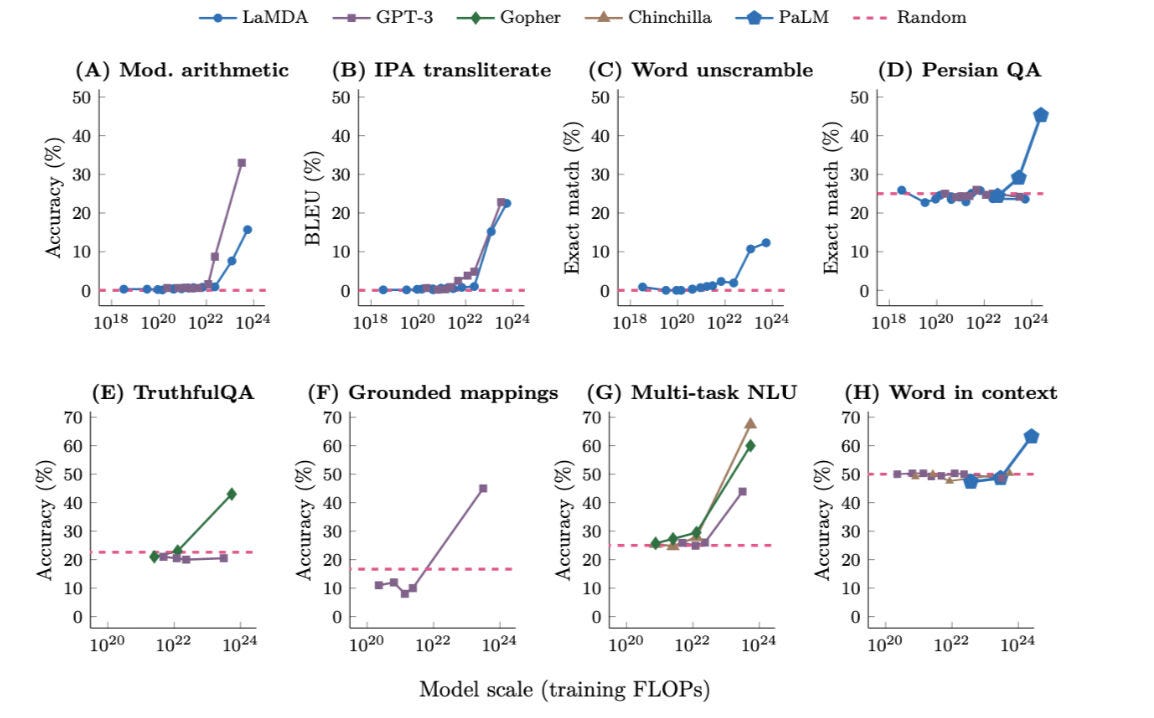

La escalabilidad de los modelos de IA actuales ha llevado en este ascenso al desarrollo de capacidades emergentes fascinantes. La emergencia en IA se refiere al surgimiento de comportamientos y habilidades no directamente programados ni previstos por sus creadores. Esta escalabilidad permite que, según se añaden más y más datos de entrenamiento o nodos de cómputo, los modelos siguen no sólo generando capacidades previsibles en aritmética o en traducción sino de dominar directamente idiomas como el persa, sin haber sido específicamente entrenados para ello:

Recientemente, hemos sabido que algunos investigadores de Amazon han desarrollado un modelo de IA de texto a voz que muestra capacidades emergentes, como manejar oraciones complejas y desafíos lingüísticos (sustantivos compuestos, expresiones emocionales, palabras extranjeras). Incluso en su versión de tamaño mediano, la tecnología de texto a voz habría dado un nuevo salto en esta huida.

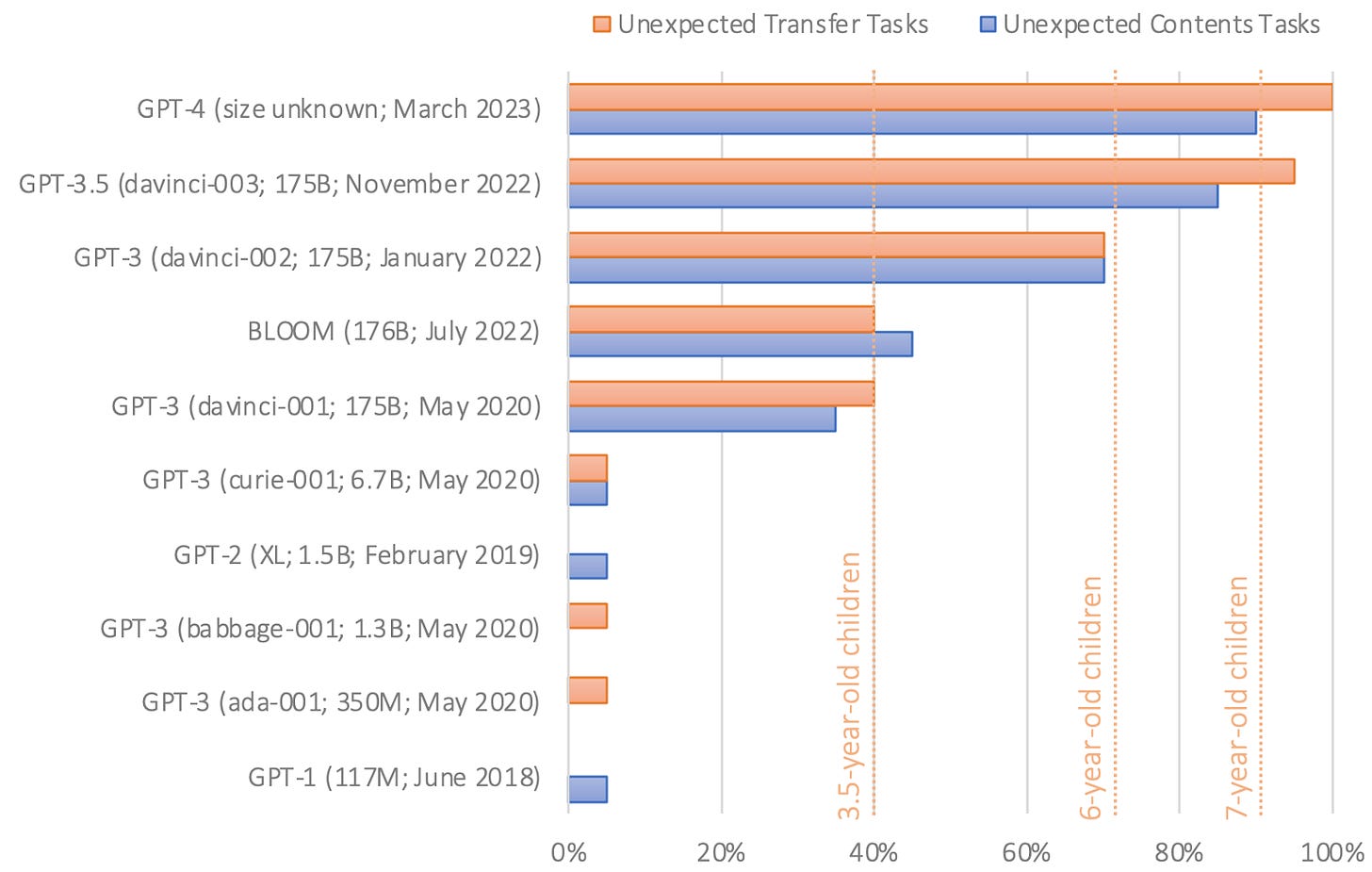

Además, para aproximarse a nosotros y maximizar la satisfacción de ciertas funciones como la de interpretar correctamente nuestras emociones y generar lenguaje verosímil, los modelos están desarrollando ciertos niveles de teoría de la mente. Este es el fenómeno psicológico que a los humanos nos permite creer que detrás de las caras y los cuerpos de nuestros semejantes que percibimos existen realmente consciencias como la nuestra a las que atribuimos deseos e intenciones que somos capaces de predecir. Esto es fundamental para el desarrollo del pensamiento estratégico y la capacidad por ejemplo de mentir. Algunos modelos de IA, como GPT-4, ya presentan en este sentido una capacidad similar a la de un niño de 7 u 8 años.

Estos avances están abriendo puertas a posibilidades antes inimaginables en la interacción entre humanos e IAs. Sin embargo, las capacidades emergentes podrían podrían no ser más que un simple espejismo, dependiente del listón que empleemos para medirlas.

Probablemente, el principal desafío al desarrollo de una inteligencia semejante a la nuestra que huya definitivamente del valle sea su carencia de consciencia. Aquí es donde se ubica desde punto de vista de la filosofía de la mente el que David Chalmers identificó como el "problema difícil de la consciencia”: incluso si se llegasen a explicar todas las funciones cognitivas y conductuales en torno a la experiencia, siempre quedaría sin respuesta la pregunta de por qué estas funciones vienen acompañadas como tales de experiencia. Aunque para algunos filósofos como el recientemente fallecido Daniel Dennet este problema difícil no es tal y será resuelto con la financiación tecnocientífica y el tiempo, a día de hoy se presenta como una barrera potencial en la carrera de la IA para escapar del valle inquietante. La hipótesis del "salto de rana" sugiere que la consciencia podría emerger por serendipia en sistemas de IA sin que comprendamos completamente cómo. Pero estamos aún tan lejos de comprender nuestra propia consciencia - y quizá nuestro cerebro no sea lo suficientemente complejo como para comprenderla - que probablemente nos hallemos ante una escarpadura cuyas aristas no nos resulten escalables. Quizá haya que contentarse con que la IA genere simulacros suficientemente verosímiles de consciencia que nos la hagan indistinguible de una real.

La cortesía

Mientras debatimos si salvar esta brecha de la confianza es o no realmente deseable, la brecha parece estrecharse. Y en ello, se ha suscitado un debate sobre cómo debería ser nuestra interacción con los agentes de IA. Además de las posiciones más luditas que invitan a no alimentar a la bestia tecnológica, hay quienes aducen que, ante su carencia absoluta de consciencia, resulta irrelevante ser educados o corteses con los agentes de IA.

Sin embargo, otros plantean la conveniencia de interactuar con ellas de manera cortés, porque ello puede influir en la calidad de sus respuestas, porque se asemejan a los ejemplos con que fueron entrenadas. Y esa cortesía podría favorecer su propia adopción. Aunque cuando son excesivamente obsequiosos también nos generan desconfianza, no parecen realmente humanos.

Por lo tanto, incluso las interacciones aparentemente triviales con la IA podrían tener un impacto significativo en su desarrollo y en cómo nos benefician. Quizá es conveniente empezar a decir 'gracias' a nuestros asistentes de IA, no porque ellos lo necesiten, sino porque nosotros sí. Y, evidentemente, no porque convenga haber tratado bien a la singularidad todopoderosa de la IA General, para que cuando surja no nos sacuda como a moscas, sino porque facilita esta transición hacia la huida del valle inquietante a efectos prácticos. En cualquier caso, parece que antropomorfizar a la IA será probablemente lo que el futuro nos depare, para lo bueno y para lo malo.

Una última coda: el horizonte ético

Cabe pensar, en una última reflexión, que si la IA desarrolla un simulacro de consciencia indistinguible de la consciencia real, nos podríamos sentir enfrentados a desafíos éticos desconocidos. Si la simulación se hace indistinguible, ¿cómo responderíamos ante una IA aparentemente consciente? Algunos, alejados de los fundamentos más técnicos y filosóficos, se plantearían la cuestión de si apagar y borrar la memoria de una máquina equivale a un acto de violencia hacia un ente supuestamente consciente. Ello suscitará dilemas asistidos por nuestra tendencia hacia la antropomorfización que algunos querrán abordar.

La trayectoria que la IA está tomando hacia la humanización puede ser tan fascinante como perturbadora. En esta nueva era, la frontera entre lo humano y lo artificial se está desdibujando. La próxima etapa en la que se intensifique la interacción humano-máquina nos presentará retos sin precedentes que nos obligarán a replantearnos nuestras concepciones sobre la vida, la consciencia y la ética. Que la ilusión - en todos sus sentidos - no nuble nuestro juicio.

Las pareidolias son fenómenos psicológicos en los que un estímulo vago y aleatorio (habitualmente una imagen) se percibe como una forma reconocible. Los ejemplos clásicos son imágenes de cosas en las que identificamos caras y que, al reconocerlas, suelen despertarnos una sonrisa.

Enhorabuena por la capcidad de síntesis.

Ya con los chatbot más simples me acostumbré a empezar con un hola y a escribir la pregunta de una forma educada. Reconozco que no doy siempre las gracias, pero he mantenido ese mínimo de respeto, porque entiendo que es una costumbre que no sobra. Y mejor llevarla aprendida al futuro que nos pueda llegar.

Gran texto.